Wie erkläre ich es meinem Kinde - Künstliche Intelligenz

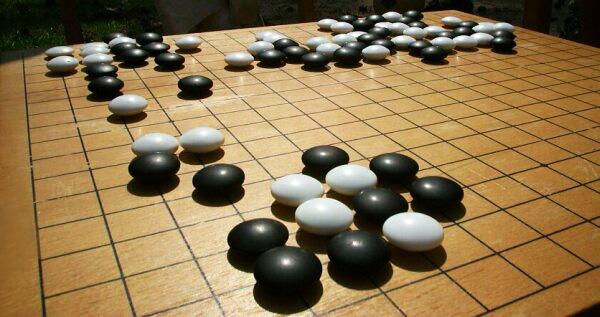

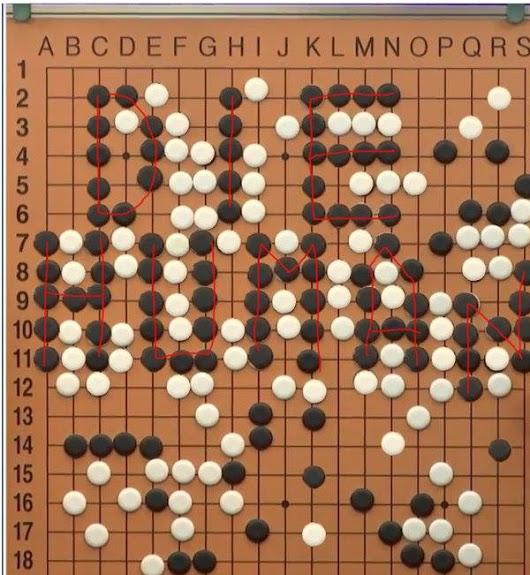

In den letzten Tages ist etwas geschehen, von dem ich nicht erwartete, es überhaupt zu erleben. Entsprechend erschüttert war ich, so erschüttert, dass mich die Kinder fragten, was denn los sei. AlphaGo hatte das dritte Spiel gegen Lee Sedol gewonnen. Aber nicht der Gewinn des Spiels war mein Problem, sondern die Art und Weise: Der Mensch hat anscheinend fehlerfrei gespielt, die Maschine dagegen hat mit unerklärlichen Zügen gewonnen.

Künstliche Intelligenz

Was ist das Besondere an einer Maschine, die Go spielt?

Im Gegensatz zu vielen anderen Spielen (auch Schach), sind die Varianten des Spieles so unüberschaubar, dass man Go eher aus dem Gefühl heraus spielt, als einem logischen Weg zu folgen. Man bewertet eine komplexe, unübersichtliche Situation nach intuitiven Maßstäben und handelt aus dem Bauch heraus.

Im Go zu brillieren heißt also, über eine hervorragende Intuition zu verfügen und mit sicherem Bauchgefühl zu spielen. Das sind normalerweise nicht die Merkmale, die man einem Computerprogamm zuschreibt.

In diesem Sinne ist AlphaGo auch nicht programmiert, sondern trainiert worden. Das Programm ist so aufgebaut, dass es eine Art Gehirn nachbildet und dieses Gehirn lernt dann über eine längere Zeit anhand von Beispielen und konkreten Vorgaben.

Die Vorgaben waren bei AlphaGo der Schlüssel zum Erfolg. Man hatte dem Programm eine Art Instinkt eingesetzt, der es ihm ermöglichte die Spielzüge zu verstehen, die normalerweise nie ausgespielt werden.

Denn Go ist ein Spiel der Andeutung: Man spielt praktisch nie die Konsequenzen bis zum bitteren Ende. Die Spielstellungen bleiben halbfertig auf dem Brett, Gebiete werden nicht gesichert, Angriffe nicht zu Ende gespielt. Ohne Konsequenzen ist aber das Lernen schwierig, denn die Korrektur falschen Verhaltens fehlt.

Das ist durchaus ein Problem der klassischen Pädagogik: Man muss sich nicht die Finger an der heißen Herdplatte verbrennen, mit der Gabel in die Augen stechen, oder mit dem Fahrrad vor die Hausmauer fahren, um gefährliches Handeln zu unterlassen. Dieser Teil des Lernprozesses ist rein abstrakt, er spielt allein mit der Vorstellung möglicher Folgen.

Bisherige Modelle der künstlichen Intelligenz, d.h. nach gebauten Gehirnen, wurden trainiert, indem sie ein komplettes Handlungsbeispiel vorgesetzt bekamen und für die korrekte Handlung belohnt, für eine fehlerhafte Handlung bestraft wurden. Das simulierte Gehirn hat dann die günstigen Verbindungen bevorzugt und die ungünstigen Vernetzungen abgebaut. Ganz wie in einem menschlichen Gehirn.

Bei AlphaGo wurde das Programm mit Beispielpartien von Go-Wettkämpfen gefüttert. Um das Spiel der Andeutungen verstehen zu können, ist es aber notwendig, den angedeuteten Gedanken zu Ende führen zu können und das wurde dem Programm für eine Reihe elementarer Fälle fest einprogrammiert. Auf diese Weise konnte die Software eine völlig klare Spiel-Situation final und korrekt beurteilen. Allein aus dem Training heraus wäre das mangels zu Ende gespielter Beispielpartien nicht erlernbar gewesen.

Künstliche Intelligenz ist also eine Gehirnsimulation, die in der Lage ist, Verhalten durch Training zu erlernen.

Verstehen, was passiert

AlphaGo ist bei weitem nicht der erste Versuch, mit einer künstlichen Intelligenz zu arbeiten. Das Forschungsgebiet ist schon sehr alt. Es wird normalerweise betrieben, um zu verstehen, wie Denkprozesse ablaufen.

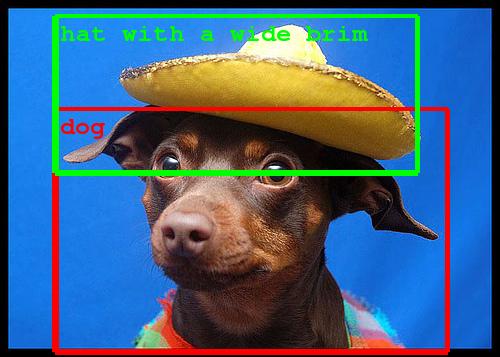

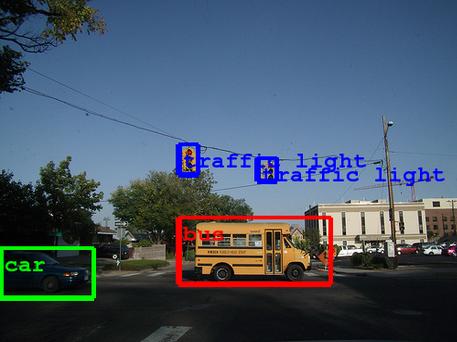

Ein Beispiel: Google versucht – wie viele andere Unternehmen auch – Bilder zu verstehen. Dabei geht es darum, in Worte zu fassen, was auf dem Bild dargestellt ist. Für uns Menschen eine einfache Aufgabe. Für einen Computer ein ernsthaftes Problem.

Das entsprechende Forschungsprojekt von Google zeigte prima Ergebnisse:

Wofür man das brauchen kann, ist auch völlig logisch: Ein autonomes Fahrzeug muss seine Umgebung wahrnehmen können.

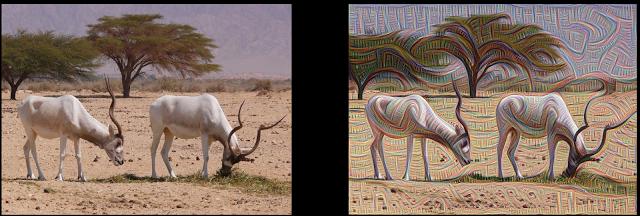

Das eigentlich Interessante daran, ist die Art, wie der Computer zu diesen Ergebnissen gekommen ist. Dazu wird das simulierte Gehirn genau untersucht.

Es stellte sich heraus, dass die Bilderkennung in mehreren Schichten abläuft:

- Zuerst werden Kanten ermittelt

- dann werden die Kantenlinien zu bestimmten Mustern gruppiert, wobei die Orientierung nicht mehr wichtig ist

- die Muster werden zu größeren Gruppen zusammengefasst

- und die Gruppen im Verhältnis des Gesamteindrucks (was ist alles auf dem Bild?) kategoriersiert

Witzigerweise kann man die ersten Schritte auch vernünftig visualisieren und verstärken. Dabei entstehen ästhetisch ansprechende Bilder (in einem frühen Stadium) oder verstörendende Überlagerungen (in die späteren Schritten). Gerade letztere haben dem Algorithmus den Namen DeepDream eingegeben. Es hat nämlich den Eindruck, als ob Computer träumen.

Wirklich nützlich dagegen sind die überraschenden Einsichten, was so ein Computer genau gelernt hat. Am Beispiel einer Hantel hatte die Maschine nämlich ganz andere Dinge für wichtig erachtet als der Mensch.

Man sieht deutlich, dass der Computer den Arm des Kraftsportlers als integralen Bestandteil der Hantel ansieht. Schließlich hat man das Programm mit hunderten Fotos aus Fitness-Studios trainiert. Und dem Computer fehlt das notwendige Verständnis, den Arm als irrelevant weg zu lassen.

Im Ganzen gesehen, ist bis hierher nichts besonders überraschend. Der Mensch hat sich Hilfsmittel gebaut, die schnell und zuverlässig eine Aufgabe erledigen. Er versteht, was dabei passiert und kann im Zweifel die Vorgänge im Einzelnen überprüfen.

Der Schreck

Schon nach den ersten Partien zwischen AlphaGo und Lee war die Überraschung groß. Denn AlphaGo spielte ungewöhnlich.

Eine Maschine, die Millionen von Partien gegen sich selbst gespielt hat, kann durchaus feststellen, welche Züge bisher nicht genügend Beachtung gefunden haben und diese einfach mal ausprobieren. Das Ergebnis ist dann ein ungewöhnlicher Spielzug, der einen menschlichen Gegner verunsichern kann. Der Mensch beurteilt die Situation dann falsch und verliert. An dieser Stelle kann man von dem Programm lernen, den menschlichen Erfahrungsschatz erweitern und die neuen Züge analysieren.

Im dritten Spiel trat aber etwas mehr als ungewöhnliches auf: Die Kommentatoren war plötzlich der Meinung, die Maschine spiele fehlerhaft, während der Mensch korrekt handle. Allerdings verlor der Mensch kurz darauf.

Das qualitativ Neue an der Situation ist, dass der Mensch nicht mehr erklären kann, was da eigentlich passiert ist. Und das macht Angst.

Eine künstliche Intelligenz, deren Entscheidungen sich unserem menschlichen Verständnis entziehen, hat etwas bedrohliches. Sie greift direkt die geistige Vormachtstellung des Menschen (in seinem eigenen Selbstverständnis) an.

Die Kommentatoren flüchten sich in emotionale Gebiete. Die Formulierung "Sie spielt wie eine Göttin" muss man sich auf der Zunge zergehen lassen. Der Kommentator hat die Maschine vermenschlicht und bewundert ihre Intelligenz. Man hört ebenfalls heraus, dass die Maschine "wusste, dass sie gewinnen werde".

Unplanbare Schritte

Völlig unabhängig davon, ob es gelingt diese Partien im Detail zu analysieren und die neuen Spielzüge zu verstehen, muss ein anderer Gesichtspunkt berücksichtigt werden.

Die Zwischenschritte, die eine künstliche Intelligenz durchschreitet, um an ihr Ziel zu kommen, sind nicht durch Training erlernt worden. Der Mensch hat der Maschine also nicht beigebracht, auf welchem Wege das Ziel zu erreichen ist. Die Maschine hat sich selbst den Weg zum Ziel überlegt.

Solange es sich um ein Brettspiel handelt, ist es unerheblich, wie eine Maschine handelt. Verlässt man aber das Spielfeld und kehrt in die reale Welt zurück, so muss man sich wirklich Gedanken machen.

Wenn eine solche künstliche Intelligenz damit beauftragt wird, autonom ein Auto zu fahren, welche Reaktionen soll sie in bestimmten, unübersichtlichen Situationen zeigen? Muss dann der Computer über Leben und Tod entscheiden? Diese Debatte läuft, aber sie behandelt den Fall immer noch unter dem Gesichtspunkt, wir könnten der Maschine an dieser Stelle Vorschriften machten. Das werden wir voraussichtlich nicht können. Weil wir die Maschinen dafür nicht mehr genau genug verstehen.

Wenn eine solche künstliche Intelligenz damit beauftragt wird, in einem Krankenhaus die Patienten zu überwachen (ja, das ist DeepMind) und zu medikamentieren, genügt uns dann eine 15% höhere Überlebenswahrscheinlichkeit als Erfolg? Oder wollen wir auch verstehen, warum bestimmte Patienten nicht durchgekommen sind? Vielleicht war deren Tod Voraussetzung für das Überleben anderer Kranker. Vielleicht deshalb, weil der Computer dort Anzeichen einer Infektionskrankheit gesehen hat, die sich im gesamten Klinikum auszubreiten drohte. Und da er über keine anderen Mittel verfügte, als die Medikamente zu dosieren, hat er diesen Zwischenstand in Kauf genommen.

Wenn eine solche künstliche Intelligenz damit beauftragt wird, die begehrten Studienplätze in Deutschland gerecht zuzuteilen, warum sollte sie nur auf den Notendurchschnitt schauen? Warum sollte sie nicht auch ein gesamtgesellschaftliches Ziel berücksichtigen und damit die jungen Leute an den Ort schicken, wo sie aus Sicht des Computers am nützlichsten sind. Oder warum sollte nicht auch in die Entscheidung einfließen, wie hoch die Wahrscheinlichkeit eines Studienabbruchs ist? Wer kann denn hinterher kontrollieren, auf welche Weise die Maschine zu dieser Auswahl gekommen ist?

Was mir also ernsthafte Bauchschmerzen bereitet, ist eine Tatsache: Die von der künstlichen Intelligenz angesteuerten Zwischenschritte unterliegen keiner ethischen Kontrolle, sondern ausschließlich der Nützlichkeit bei der Erreichung des Zieles.

Genau dieser Punkt hat die Kommentatoren des dritten Spiels von AlphaGo gegen Lee Sedol verunsichert. Während Herr Lee die Komplexität des Go-Spiels anhand langer Traditionen auf einige wenige zulässige Gassen einschränkt, kennt die Maschine keine solchen Skrupel.

Und wir erleben soeben den Punkt, an dem wir unsere eigene Schöpfung nicht mehr verstehen. Ein Punkt, den ich nicht zu erleben glaubte.

Ich habe also Asimov gelesen.

2 Kommentare